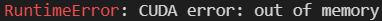

Si vous rencontrez souvent une erreur de PyTorch qui vous indique que vous n’avez plus de place mémoire libre, vous aurez certainement envie de connaître l’espace mémoire disponible et utilisé par votre GPU.

Mais comment faire?

Je vous propose la solution suivante.

La fonction mem_get_info de torch.cuda permet justement de récupérer un couple d’entiers donnant accès à l’espace mémoire utilisé par CUDA.

Le premier entier correspond à la mémoire disponible, donnée en kilo-octets. On divisera donc par 1024, trois fois, pour avoir le résultat en giga-octets.

Le second correspond à la mémoire totale existante. Là encore en kilo-octets, donc on divisera de même par 1024, trois fois, pour avoir la valeur en Go.

Laisser un commentaire